政策驱动下的虚拟现实教室建设背景

023年工业和信息化部、教育部、文化和旅游部、国务院国资委、国家广播电视总局办公厅联合印发年国家《元宇宙产业创新发展三年行动计划(2023-2025)》,以及在2022也联合印发《虚拟现实与行业应用融合发展行动计划(2022—2026年)》要求2026年落实建设虚拟现实相关教室,开发数字教学课程等文件。地科院拟启动虚拟仿真系统建设,为未来教育提供技术支持和创新保障。

打造沉浸式教学环境:虚拟现实教室建设内容

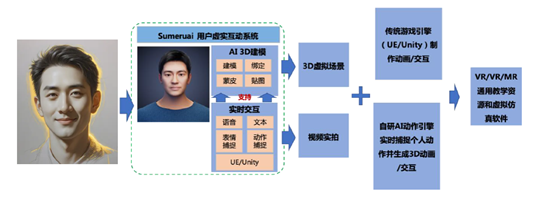

核心引进一套元宇宙互动内容生产引擎。元宇宙互动内容生产引擎即将3D建模、动画/交互开发以及渲染无代码化,轻量化,让C端用户可在个人PC、移动端等设备上直接使用,实现用户自定义3D内容生产(UGC)。

元宇宙互动内容生产引擎是面向C端用户,运用VR、3D计算机图形学和AI技术,使用引擎,开发者即可快速、低成本的开发接近100%模拟现实体验的元宇宙VR内容。开发者在开发环境中直接调用接口,即可实现快速生成每个参与应用的C端用户的高品质高写实3D虚拟化身,并已自动完成骨骼绑定,blend shape绑定,蒙皮和贴图制作,可直接导入3D开发引擎(如Unity、UE)中进行交互开发;同时,引擎包含一套AI实时捕捉内容并生成系统,用户通过一个单目RGB摄像头,即可实时捕捉并生成自己的表情、动作的3D动画。

3D交互引擎--实现VR/AR/MR多场景应用的高效开发

满足交互式理论教学、虚拟仿真实验、沉浸式科研以及全息可交互成果展示等多方面的需求,引擎开发的3D 交互内容,可同时投放到3D 虚拟场景和现实视频拍摄场景中——即既可实现VR 场景下的虚拟仿真和科研应用,又可实现AR/MR 场景下的教学和成果展示应用。整个开发过程无需特殊装备投入以及专用软件和算法的学习,兼容市场上所有主流的VR/AR/MR 设备。

虚拟人养成系统--师生的个性化互动体验

师生可将文本、声音、视频素材输入“养成系统”,训练虚拟人的人设、性格和知识库等,并与虚拟人做实时交流互动。师生输入的文本以“提示词”或“RAG”的方式与大模型交互,并生成新的文本内容;师生输入的语音首先由AI识别并转化成文字,并输入大模型,生成新的内容后,再转化成语音,并通过语音驱动虚拟人AI生成相应的语音、表情、口型和动作,与师生交互。整个服务为流式数据传输,以保证交互低延迟。同时系统支持师生上传动作视频,让虚拟人生成与视频里动作一致的3D虚拟人动画,实现元宇宙动画制作和个性化师生互动。

3D 虚拟人AI 生成与交互系统以插件的形式安装到本地工作站,同时算法API 部署在云端,通过SaaS 的方式与各交互终端设备连接。AI 动作捕捉及实时生成引擎系统部署到本地工作站。